О идеји да вештачка интелигенција збаци човечанство расправљало се деценијама, а у јануару 2021. научници су дали своју пресуду о томе да ли можемо да контролишемо компјутерску суперинтелигенцију високог нивоа. Одговорити? Готово сигурно не.

Проблем је у томе што би контрола надумом далеко изван људског разумевања захтевала симулацију тог суперума који бисмо могли да анализирамо. Али ако нисмо у стању да то разумемо, немогуће је направити такву симулацију.

Правила попут „не штетите људима“ не могу се успоставити осим ако не разумемо које сценарије ће вештачка интелигенција (АИ) смислити, сматрају аутори рада из 2021. Чим рачунарски систем буде радио на нивоу који превазилази могућности наших програмера, више нећемо моћи да постављамо границе.

"Суперинтелигенција је фундаментално другачији проблем од оних који се обично проучавају под заставом 'роботске етике'", пишу истраживачи. „То је зато што је суперум вишеструк и стога потенцијално способан да мобилише различите ресурсе за постизање циљева који су људима потенцијално недокучиви, а камоли контролисани.

Део образложења тима долази из проблеми са заустављањем, који је предложио Алан Туринг 1936. године. Изазов је схватити да ли ће компјутерски програм доћи до закључка и одговорити (и престати) или ће се само заувек мотати у покушају да пронађе одговор.

Као што је Тјуринг доказао уз помоћ интелигентна математика, иако то можда знамо за неке специфичне програме, логично је немогуће пронаћи начин који би нам омогућио да то знамо за сваки потенцијални програм који би икада могао бити написан. Ово нас враћа на вештачку интелигенцију, која би у суперинтелигентном стању могла да складишти све могуће компјутерске програме у својој меморији у исто време.

Такође занимљиво:

- ОпенАИ је учио вештачку интелигенцију да конвертује команде у програмски код

- Вештачка интелигенција ће тражити гравитационе таласе

Било који програм написан, на пример, да спречи вештачку интелигенцију да наноси штету људима и уништи свет може, али не мора да дође до закључка (и заустави) – математички је немогуће бити апсолутно сигуран на било који начин, што значи да се не може обуздати. „То у основи чини алгоритам одвраћања неупотребљивим“, рекао је у јануару компјутерски научник Ијад Рахван са Института Макс Планк за људски развој у Немачкој.

Алтернатива подучавању етике вештачке интелигенције и забранама уништавања света, у шта ниједан алгоритам не може бити потпуно сигуран, кажу истраживачи, јесте ограничавање способности суперума. На пример, може бити одсечен од дела Интернета или одређених мрежа.

Аутори недавне студије одбацују и ову идеју, сматрајући да ће ограничити обим вештачке интелигенције – кажу, ако нећемо да је користимо за решавање проблема изнад људских могућности, зашто је онда уопште стварати?

Ако желимо да унапредимо вештачку интелигенцију, можда нећемо ни знати када ће се суперинтелигенција појавити, ван наше контроле, толико је недокучива. То значи да морамо почети да постављамо озбиљна питања о томе куда идемо.

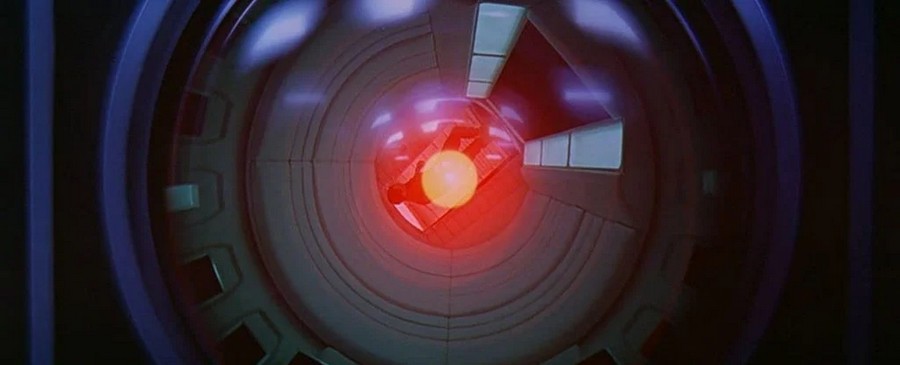

„Суперинтелигентна машина која управља светом звучи као научна фантастика“, каже компјутерски научник Мануел Кебријан са Института Макс Планк за људски развој. Али већ постоје машине које самостално обављају неке важне задатке, док програмери не разумеју у потпуности како су то научили.

Стога се поставља питање да ли то у једном тренутку може постати неконтролисано и опасно по човечанство...

Прочитајте такође:

- Вештачка интелигенција успела је да репродукује насликану Пикасову слику

- Вештачка интелигенција ће помоћи у предвиђању саобраћајних несрећа пре него што се догоде